Linux (fr)

-

Discourse, plate-forme de discussion atypique

(Dépêches LinuxFR)

Jeff Atwood, connu entre autres pour Stack Overflow, a annoncé la sortie de la plateforme de discussion Discourse en version 1.0 le 26 août 2014 et en version 1.4 le 22 septembre 2015. La devise du projet est « Civilized Discussion. On the Internet. », soit « Discussion civilisée. Sur Internet. ».

En résumé, Discourse fonctionne à la fois comme une liste de diffusion, un forum de discussion et un salon de discussion… Il est développé en Ruby on Rails, avec Ember.js, basé sur du PostgreSQL et du Redis. Il est distribué sous la licence GNU GPL v2.

- lien n°1 : Pourquoi Discourse ?

- lien n°2 : Fonctionnalités

- lien n°3 : Code source sur GitHub

- lien n°4 : Démonstration de Discourse

- lien n°5 : Introducing Discourse 1.0

- lien n°6 : Caricature Geektionnerd sur la sortie de Discourse 1.0

- lien n°7 : Article Wikipédia anglophone

- lien n°8 : Installer Discourse

- lien n°9 : Discourse 1.4 Released!

Sommaire

- Motivations autour du lancement du projet

- Fonctionnalités de Discourse

- Principes d’une discussion civilisée

- Installation

- Technologies

- Modèle économique

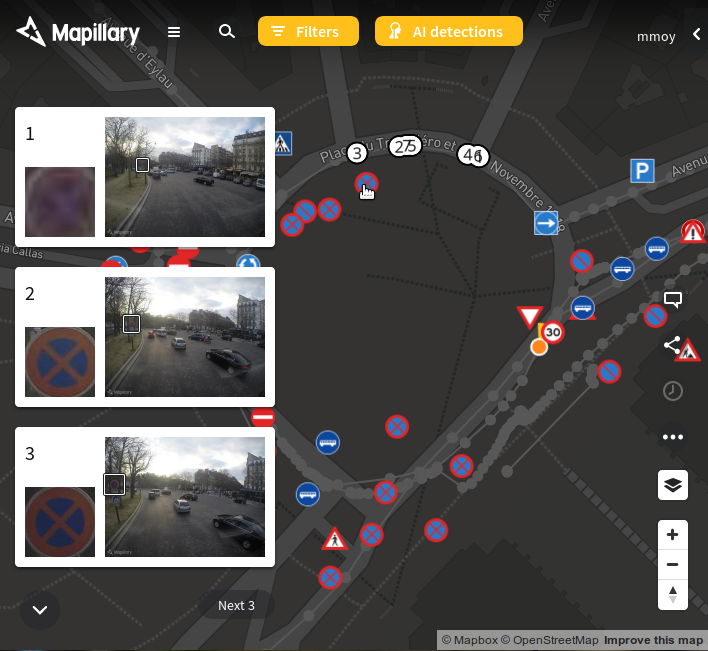

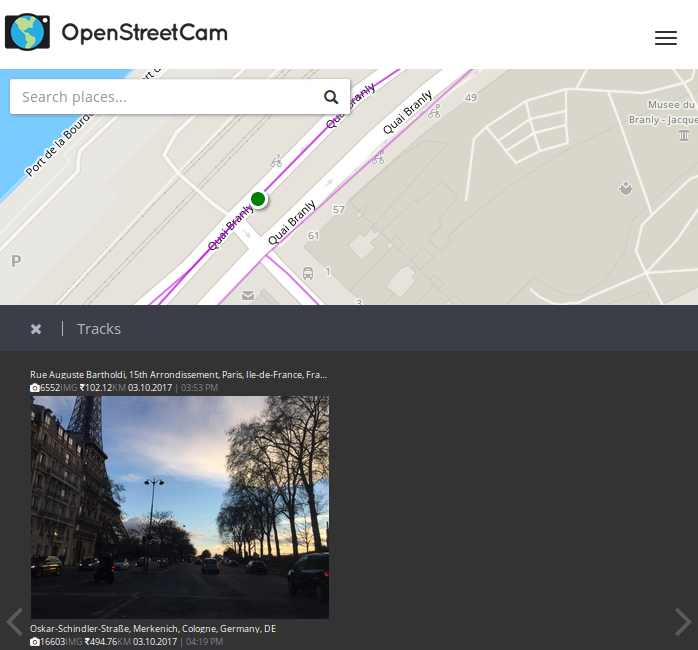

Interface principale de Discourse en version 1.3.Motivations autour du lancement du projet

Extrait de l'annonce du lancement du projet en juillet 2013 :

Un des trucs qu'on a appris avec Stack Exchange est que, si ton but est d'améliorer le rapport signal sur bruit, tu dois réfréner les discussions.

Stack Exchange ne permet que le minimum absolu de discussion nécessaire à la production de bonnes questions et réponses. D'où la réorganisation constante des réponses par les votes, d'où les limites de formatage et de longueur des commentaires, le fait que peu s'affichent, et ainsi de suite. Presque toutes nos décisions de conception furent motivées par notre désir de réduire la discussion, de l'inhiber de toutes les façons possibles. Épargne-nous l'étalage kilométrique de ton avis, et réponds juste à la foutue question.

Après quatre années pleines à considérer la discussion comme l'Empire établi et corrompu, et Stack Exchange comme l'Alliance Rebelle, j'ai commencé à me demander - qu'est-ce que ça ferait de changer de camp ? Et si je devenais le champion de la discussion spontanée et impulsive, du genre que j'ai passé quatre ans à combattre aux niveaux conceptuel et spirituel ?

Fonctionnalités de Discourse

Rédigé d'après la FAQ et la page « à propos » :

- 100 % libre : intégration de Discourse dans votre site en totale confiance ; le code appartient à tous ;

- Système de confiance : au fur et à mesure que les utilisateurs deviennent des membres de confiance, ils peuvent devenir des modérateurs de leur communauté ;

- Responsive pour mobiles : conception pensée depuis le premier jour pour les écrans tactiles ; modes d'affichage automatiques qui s'adaptent à votre support mobile et/ou tactile ;

- Modération par la communauté : un système de drapeau permet à la communauté de supprimer les spams et les contenus dangereux et de résoudre amicalement ses propres disputes ;

- Optimisé pour la lecture : pour continuer à lire, faites simplement défiler la page ; quand vous atteignez le bas de page, des sujets suggérés vous amènent à rester dans votre lecture. La discussion n’est pas coupée en plusieurs pages ;

- Likes : exprimez votre accord, votre soutien, et mettez en avant des commentaires intéressants avec le gros bouton ❤ présent sur chaque commentaire ;

- Dégrossir les fil de commentaires : Bouton « Summarize » pour condenser les longs fils de discussions et n'afficher que les commentaires les plus intéressants et populaires ;

- Contexte en ligne : affichage des citations, des réponses ou du fil de discussion qui précédait une réponse ;

- Traductions : disponible dans 17 langues, et plus à venir ; les utilisateurs peuvent configurer la langue de leur choix ;

- Notifications en temps réel : avertissement quand quelqu'un vous répond, vous cite, mentionne votre @nom, vous envoie un message privé, crée un lien vers votre commentaire, modifie votre commentaire, ou re-catégorise votre discussion ;

- Référencement : URL lisible et compréhensible et HTML valide, optimisé pour l'indexation par le moteur de recherche de Google ;

- Greffons : système de greffons en cas de besoin de fonctionnalité spécifique à votre site ;

- Single Sign On : intégration fluide avec le système d'identification du site hôte ;

- Éditeur en surimpression : rédaction des commentaires dans un éditeur qui n'interrompt jamais la lecture, même si vous visitez un autre fil de discussion ;

- Identification via sites sociaux : ajout facile de Google, Facebook, Twitter, Yahoo!, GitHub, et d'autres systèmes d'identification courants ;

- Communautés privées : catégories entièrement ou partiellement privées ;

- Limitations : toutes les actions utilisateurs peuvent être soumises à des contraintes, par exemple très strictes pour les nouveaux utilisateurs ;

- Nettoyage facile du spam : suppression des spams en deux clics, bannissement d'adresse de courriel et d'IP et auto-suppression de tous les contenus associés ;

- Blocage du spam : heuristique uniforme et exhaustive, incluant un sas pour les nouveaux utilisateurs, le blocage par les utilisateurs, et l'utilisation de l'attribut nofollow ;

- Analyses : tableau de bord pour les administrateurs listant les statistiques clés des utilisateurs, les sujets de discussion et toutes les actions des utilisateurs, en incluant les domaines et sujets les plus en vogue ;

- Intégration automatique d'URL : les URL de sites populaires comme Wikipédia et YouTube incluront un résumé. Prise en charge complète de OpenGraph et oEmbed ;

- Gestion avancée des images : téléversement d'images via sélection de fichier, glisser/déposer ou copier/coller ; les grandes images sont automatiquement réduites en miniatures et affichées à l'aide de lightbox ;

- Adjonction de fichiers : inclusion de fichiers de toutes sortes et de toutes tailles ;

- Suivi de liens : les liens externes sont accompagnés d'un compteur de clics ; les liens entrants et sortants vers d'autres sujets sont affichés à coté de chaque commentaire ;

- Sondages : création rapide de sujets sur lesquels la communauté peut voter ;

- Spoilers : étiquettes qui floutent les spoilers (information cruciale qui déflore le sujet central) éventuels, ne se révélant que par un clic ou un appui ;

- Formatage flexible : mélange possible de Markdown, de BBCode et de HTML ;

- Emoji : commencer juste à taper pour avoir accès à une liste complète des emoji courants ;

- API exhaustive : tout ce qui est visible à l'écran est accessible via l'API. Discourse lui-même est une application en JavaScript qui communique avec une API ;

- Avatars locaux : génération d'avatar locaux sans dépendances externes. Possibilité de choisir un Gravatar existant ou de téléverser son avatar ;

- Invitation par courriel : les utilisateurs de confiance peuvent inviter des amis par courriel à rejoindre et participer à une discussion par un simple clic ; les administrateurs peuvent inviter des utilisateurs par groupes en renseignant une liste d'adresses courriel ;

- Brouillon automatique : les réponses et sujets sont automatiquement sauvés sur le serveur en arrière plan pendant leur rédaction ;

- Historique des révisions : suivi des révisions à chaque modification, avec mise en évidence visuelle des différences pour faire apparaître les changements ;

- Commentaires wiki : les commentaires peuvent être déclarés comme modifiables par des membres de confiance de la communauté ;

- Badges : les comportements positifs sont encouragés par un ensemble de badges préexistants ou de votre cru ;

- Notification par courriel : quand vous n'êtes pas activement sur le site web, vos notifications seront envoyées par courriel ;

- Réponse par courriel : répondez aux notifications par courriel pour participer sans visiter le site web ;

- Modération en ligne : outils de contrôle rapide en ligne pour séparer, joindre, fermer, archiver ou re-catégoriser des sujets ;

- File d'attente de drapeaux de modération : très visible, avec notification optionnelle par courriel. Un clic pour exprimer un accord, un désaccord, ou déférer un drapeau (à un autre modérateur).

- Notification sur tout le site : punaiser des sujets localement ou globalement. Affichage d'un sujet pour qu'il soit immanquable par tous les utilisateurs ; alerte permanente pour des situations urgentes ;

- Prise en charge des listes de diffusion : mode spécial pour lequel tous les messages sont envoyés par courriel, comme une liste de diffusion. Démarrage de nouveaux sujets par courriel ;

-

Espace « communauté » : sous-domaine

meta.sitewebpour discuter fonctions, bugs, et demandes d'aide. - Messages privés : envoi de messages privés à un ou plusieurs utilisateurs ;

- Sauvegarde et restauration sur le web : toutes les données du site sont enregistrables et restaurables depuis le navigateur ; changez vos données de serveur en quelques clics ;

- Sauvegardes automatiques : sauvegarde de vos données tous les jours, sur le système de fichiers local ou ailleurs ;

- Prise en charge des CDN : intégration facile de tous les fournisseurs de CDN pour accélérer l'accès au site.

Principes d’une discussion civilisée

- http://blog.codinghorror.com/please-read-the-comments/

- http://blog.codinghorror.com/training-your-users/

- http://blog.discourse.org/2013/03/the-universal-rules-of-civilized-discourse/

- http://try.discourse.org/faq

Installation

Discourse s'installe à l'aide de Docker.

Technologies

D’après le README du dépôt GitHub de Discourse :

- Ruby on Rails

- Ember.js

- PostgreSQL

- Redis

Modèle économique

Le projet Discourse vend des services d'hébergement.

Projet similaire

[NdM] Le cycle de développement est rapide, environ une version tous les quatre mois. La version 1.5 devrait arriver d'ici quelques semaines.

-

HS - carte d'identité et empreinte de l'index gauche

(Journaux LinuxFR)

Bonjour tout le monde,

Ma carte d'identité arrivant à expiration je suis allé la faire renouveler.

Je remplis le formulaire, donne le justificatif de domicile et les photos (faut pas sourire , bien être au centre, etc.) je donne tout à la dame et là, elle me demande de faire une empreinte de mon index gauche !

Je n'étais pas au courant qu'il fallait donner une empreinte, je ne vous cache pas mon étonnement.

J'ai trouvé ça assez choquant d'avoir un petit bon de moi sur ce formulaire.

bref je l'ai fait quand même. Bin ouai faut bien avoir des papiers !Au final maintenant je me sens moins libre qu'hier et j'ai plein de question en tête :

- a-t-on le droit de refuser de donner ses empreintes ?

- cette empreinte sera utilisée dans quel but ?

- a-t-on un droit de regard sur ce qui est fait avec notre empreinte ?

- jusqu'où ça va aller avec ce fichage (à quand le prélèvement d' ADN ?) ?

- on fait comment quand on n'a plus d'index gauche ?

bref je voulais savoir si je suis le seul à ne pas apprécier devoir filer une empreinte ou est-ce que je commence a être un vieux con qui fait chier son monde à pas vouloir être fiché comme tout le monde ?

-

Tutorial Code_Aster

(Journaux LinuxFR)

Sommaire

Bonjour Nal', une fois n'est pas coutume, il pleut en Haute-Garonne ! Alors j'ai tué le temps jetant un œil à Code Aster. Je laisse ici mes notes.

Code_Aster, qu'est-ce c'est ?

Code_Aster est un code de calcul de structure thermo-mécanique par la méthode des éléments finis isoparamétriques.

Il est développé par EDF sous licence GNU/GPLv3.

Il permet de faire à peu près tout ce qui est imaginable en mécanique, voir à ce propos-là plaquette de présentationCe code de calcul est intégré à la suite de logiciels libres Salomé-Méca, qui contient un préprocesseur, Code_Aster, et un post-processeur/vieweur pour voir les résultats.

Aujourd'hui, nous allons utiliser le code en version stand_alone, et nous utiliserons notre éditeur de texte préferé, gmsh, astk, puis de nouveau gmsh pour voir les résultats de nos calculs.

Installation

Cela se passe ici.

Deux options:

1. Soit on compile code_aster

1. Soit on n'aime pas compiler et on télécharge le binaire de Salome-Méca qui contient code_aster de façon préinstallé, et quelques Gio d'outils dont ne nous servirons pas.La compilation se passe assez bien, et les paquets prérequis (voir les instructions de compilation sur leur site) se trouvent assez facilement.

Calcul de Poutre

Nous allons étudier le comportement mécanique d'une poutre encastrée d'un côté et soumise à un effort ponctuel de l'autre côté:

Nous allons le faire de 3 façons:

- En modélisation poutre 1D

- En modélisation plaque 2D

- En modélisation complète 3D

Création de la géométrie avec Gmsh

Pour fonctionner, Code_Aster a besoin d'un fichier de commande, et d'un fichier décrivant un maillage: une liste de nœuds et une liste d'éléments reliant ces nœuds. On pourrait lui fournir un fichier texte contenant les coordonnées géométriques de chaque nœud du maillage, mais vu qu'on a la flemme et que cela peut être assez ennuyeux pour des problèmes complexes, on va demander à Gmsh de le faire pour nous.

On crée tout d'abord la géométrie de notre problème à l'aides de points, de lignes, surfaces et volumes, on doit aussi définir des groupes d’intérêts (la poutre entière, la partie encastrée, et la partie sur laquelle on applique la force). On peut jouer 5 minutes avec la partie GUI de Gmsh pour lequel on trouvera de nombreux tutoriaux sur le web, mais on en revient vite à un fichier texte.

Voici donc poutre1d.geo:

//== parametres == //taille maillage autour des noeuds. 2.5mm entre deux noeuds. cl__1 = 2.5; // == geometrie == //points Point(1) = {0,0, 0, cl__1}; // extremite encastre de ma poutre Point(2) = {100,0, 0, cl__1}; // extremite libre de ma poutre, soumise à une force //lignes Line(1) = {1, 2}; // on cree la ligne entre Point1 et Point2 //== groupe == Physical Point("encastr") = {1}; // on encastrera le noeud correspondant à ce point Physical Point("force") = {2}; //on appliquera la force sur le noeud correspondant à ce point Physical Line ("poutre") = {1}; // notre poutre sera constitue des tous les noeuds et elements correspondant à cette ligneUne fois ce fichier poutre1d.geo crée, on l'ouvre avec gmsh (Terminal: gmsh poutre1d.geo)

On clique sur Mesh > 1D, le maillage est fait, mais on ne le voit pas car seul la géometrie est affichée ! Donc Tools > Options, Onglet Visibily de Géometrie, on décoche Points et Lines et dans Mesh, on coche Nodes and Lines. Cela donne ceci:

Notez qu'avec Tools > Options, dans l'onglet list bowser, on peut visualiser/désafficher (toucher enter du clavier une fois cliqué sur le nom du groupe dans la fenêtre) les groupes que nous avons crée et leurs affectations. C'est très pratique. On voit par exemple bien que notre groupe "poutre" est constitué de tous les éléments de la poutre.

Pour sauvegarder notre maillage, on fait File > Export et on choisit le format de maillage appelé .MED, on obtient donc un beau mesh1d.med. Surtout, on veille à ce que tout soit décoché dans la fenêtre pop-up qui apparaît et on clique rapidement sur OK.

De même, voici poutre2d.geo, qu'on maille en 2D avec gmsh:

//== parametres: == //taille maillage autour des noeuds. 2.5mm entre deux noeuds. cl__1 = 2.5; L=100; //longeur poutre de 100mm R=5; // ratio longueur/largeur l=L/R; //== geometrie == //points Point(1) = {0, 0, 0, cl__1}; Point(2) = {L, 0, 0, cl__1}; Point(3) = {L, l, 0, cl__1}; Point(4) = {0, l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 5}; Line(3) = {5, 3}; Line(4) = {3, 4}; Line(5) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4, 5}; //on cree une boucle de lignes Plane Surface(1) = {1}; // on crée une surface à partir de la boucle //== groupe == Physical Line("encastr") = {5}; // on encastrera cette ligne Physical Point("force") = {5}; // lieu application force Physical Surface("poutre") = {1}; // notre poutre 2d

Et poutre3d.geo qu'on mesh en 3D avec gmsh:

//== paramètres: == //taille maillage autour des noeuds. cl__1 = 5; L=100; //longeur poutre R=5; // ratio longueur/largeur l=L/5; //== geometrie == //points Point(1) = {0,0, 0, cl__1}; Point(2) = {L,0, 0, cl__1}; Point(3) = {L,l, 0, cl__1}; Point(4) = {0,l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 3}; Line(3) = {3, 4}; Line(4) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4}; Plane Surface(1) = {1}; Point{5} In Surface{1}; // pour que le point 5 soit contenu dans la surface //volume Extrude {0,0,-3}{Surface{1};Layers{3}; Recombine;} //on extdure la surface 1 de -3mm selon l''axe Z //en créant 3 éléments dans l''épaiseur avec l''aide de layers //== groupe == //on sait que c''est la surface 25 parce qu''on le visualise sous gmsh en affichant "surface label". //il peut y avoir une erreur lors de l''import si le numéro de la surface crée par l''extrusion n''est pas 25.' // C''est pas grave, on regarde à quoi correspond la surface à encastrer, on trouve son label, et mon modifie les lignes ci-dessous. Physical Surface("encastr") = {25}; // on encastrera cette surface Physical Point("force") = {5}; // lieu application force Physical Volume("poutre") = {1}; // notre poutre 3d //== mailage == Transfinite Line{1,3}=8*R+1; // 8*R élem dans la longueur = 41 noeuds entre lignes 1 et 3 Transfinite Line{4,2}=8+1; // 8 élem dans la largeur = 9 noeuds entre lignes 4 et 2 Transfinite Surface "*"; // on veut un maillage propre Recombine Surface "*"; // on veut un maillage quadra

Nous voici maintenant avec 3 maillages au format.med Il nous faut maitenant créer notre fichier de commande !

Fichier de commande

#U1.03.02 DEBUT(); #on charge le fichier de maillage .MED, unité logique 20 mesh=LIRE_MAILLAGE( INFO=2, INFO_MED=2, UNITE=20, FORMAT='MED', ); #on a importé le maillage et ses groupes, on crée d'autres groupes: mesh=DEFI_GROUP( reuse =mesh, INFO=2, MAILLAGE=mesh, #on crée un groupe nommé TOUT qui contient toutes les mailles du maillage. #on ne va pas s'en servir, mais ça peut être utile CREA_GROUP_MA=_F(NOM='TOUT',TOUT='OUI',), #on grée un groupe de noeud qui contient tous les noeuds de toutes les mailles. # Il faut le faire quand le maillage provient de Gmsh, car Gmsh transforme les noeuds en maille, on les retransforme ici en noeud CREA_GROUP_NO=_F(TOUT_GROUP_MA='OUI',), ); #on affecte au groupe de maille 'poutre' crée avec gmsh, # des éléments finis de types Poutre, ici POU_D_T model=AFFE_MODELE( MAILLAGE=mesh, AFFE=( _F( GROUP_MA=('poutre',), PHENOMENE='MECANIQUE', MODELISATION='POU_D_T', ), ), ); #on définit un matériaux, ici de l''acier: # Module d'Young' E = 210000 N/mm2 # Coefficient de Poisson, nu = 0.3 # masse volumique = 8e-9 tonne/mm3 steel=DEFI_MATERIAU(ELAS=_F(E=210000.,NU=0.3,RHO=8e-9),); #U4.43.03 #on assigne notre matériaux à nos mailles du groupe 'poutre' material=AFFE_MATERIAU( MAILLAGE=mesh, AFFE=_F(GROUP_MA=('poutre',), MATER=steel,), ); #U4.42.01 #On assigne à nos éléments poutre POU_D_T une section rectangulaire de largeur 20mm et d'épaisseur 3mm elemcar=AFFE_CARA_ELEM( MODELE=model, INFO=2, POUTRE=( _F( GROUP_MA=('poutre',), SECTION='RECTANGLE', CARA=('HY','HZ',), VALE=(3,20), ), ), ); #on interdit toutes rotations et translations aux noeuds du groupe 'encastr' (1 seul noeud ici). # cela simule l'encastrement encast=AFFE_CHAR_MECA( MODELE=model, DDL_IMPO=( _F( GROUP_NO=('encastr',), DX=0,DY=0,DZ=0,DRX=0,DRY=0,DRZ=0, ), ), INFO=1, ); # on applique 500N selon la direction -Z au noeud de notre groupe 'force' force_f=AFFE_CHAR_MECA( MODELE=model, FORCE_NODALE=_F( GROUP_NO=('force',), FZ=-500, ), INFO=2, ); #U4.51.01 #on compile les précédents concepts pour le calcul stat=MECA_STATIQUE( MODELE=model, CHAM_MATER=material, CARA_ELEM=elemcar, EXCIT=( _F(CHARGE=encast,), _F(CHARGE=force_f,), ), ); # Par défaut, sont calculés uniquement les déplacements et les réactions nodales aux points de gauss des éléments, je crois. # du coup on enrichit le concept "stat" pour lui demander d'autres choses. # SIEF_ELNO: ici, efforts théorie des poutres au niveau des nœuds des éléments # SIPO_ELNO: ici, contraintes dans la poutre, au niveau des nœuds des éléments # SIPM_ELNO: ici, contrainte max dans la poutre # REAC_NODA: forces/moments aux nœuds limites stat=CALC_CHAMP( reuse =stat, RESULTAT=stat, CONTRAINTE=( 'SIEF_ELNO','SIPO_ELNO','SIPM_ELNO', ), FORCE=('REAC_NODA',), ); #on imprime ça dans un fichier de sortie .med, unité logique 80. #on n'imprime que les déplacements et les contraintes # (on n'affiche pas tout ce qu'on a calculé, genre SIPM_ELNO ou REAC_NODA pourquoi pas !) IMPR_RESU( FORMAT='MED', UNITE=80, RESU=_F( RESULTAT=stat, NOM_CHAM=( 'DEPL', 'SIPO_ELNO', 'SIPM_ELNO', ), ), ); FIN();(Notez que les #U4.51.01 ou autres renvoient à la documentation )

On enregistre ce fichier texte en 1d.comm par exemple, et nous allons lancer le calcul à l'aider d'astk.Astk

Astk est l'outil permettant de mener à bien un calcul, on le lance via /opt/code_aster/bin/astk (si vous avez installé code_aster dans /opt/).

On cherche à obtenir une fenêtre qui a cette allure :

Ensuite :

- File -> New

- on choisit notre path / dossier de travail

- dans la colonne d'icônes au milieu à droite, on clique sur l’icône en forme de dossier bleu, pour aller chercher son mesh1d.med et son 1d.comm

- on clique sur l’icône du dessus pour ajouter deux lignes, puis dans type pour la ligne, on choisit mess et rmed, dans name on les appels ./log1d.mess et ./resu1d.rmed

- File -> Save_As -> 1d.astkLa colonne LU correspond à Logique Unité, c'est l'endroit de la mémoire où je ne sais quoi où on s'attend à trouver le fichier, dans le fichier.comm on a précisé que l'unité logique était 20 pour le maillage .med et 80 pour le résultat .med

Les colonnes DRC veulent dire Datas, Récrire, Compressé.Une fois que cela est fait on clique sur Run ! Le calcul est lancé, il se termine, on va voir le log1d.mess qui a était crée, il contient toutes les infos relatives au calcul.

L'information la plus importante étant la dernière ligne.Chez moi j'ai: EXECUTION_CODE_ASTER_EXIT_13223-localhost=0

Si le code renvoit 0, c'est que cela a fonctionné ! S'il renvoit 1, c'est que ça a planté et qu'il faut débuger…Résultat

Normalement tout a fonctionné, nous avons un beau resu1d.rmed que nous ouvrons aves gmsh (Terminal gmsh resu1d.rmed)

On peut donc voir les déplacements et la contrainte, tout ce dont a besoin un mécanicien pour dimenssionner des systèmes mécaniques !

Voici les paramètres sur lequels agir pour afficher le déplacement multiplié par 10. Il faut afficher des Vectors et non pas l'Original Field. Comme ci-dessous:

Pour les contraintes, SIPO_ELNO contient la contribution de chaque force/moment aux contraintes de la poutre.

C'est grossomodo un vecteur de 6 composantes que voici:

Pour les afficher une par une, on se place dans Options > Visibility > et, en bas, la première case à droite de la liste déroulante Original Field/Scalar Force/Vector/Tensor. 0 Correspond à SN et 5 correspond à SNT, par rapport au tableau ci-dessus. (Je ne sais pas trop ce que présente SIPO_ELNO par défaut)

SIPM_ELNO quant à lui présente par défaut la contrainte maximum selon XX.

Voici d'autre visu avec les modèles 2D et 3D:

Aller plus loin

Code_Aster est très vaste, il contient près de 400 types d'éléments finis ! Pour aller plus loin, n'hésitez pas à lire la doc, qui contient aussi des exemples de calcul qui sont livrés avec le code.

Je vous conseille aussi notamment l'excellent livre sous licence libre de Jean-Pierre Aubry, qui est un passage obligatoire pour prendre en main le code ! (Le code date par contre de la version 11 de Code_Aster, mais une nouvelle version est en cours d'écriture !)

On y fait notamment des analyses non-linéaires avec du contact entre pièces et du frottement.

Aster Study vient aussi de faire son apparition.Voilou cher journal, n'hésite pas à t'amuser !

Je poste en commentaire à ce journal les fichiers .comm de calcul en 2D et 3D.

-

Pimp my FnacBook

(Journaux LinuxFR)

Cher Journal,

Je t'écris pour la première fois en ce beau jour de Noël pour te parler du cadeau que j'ai trouvé ce matin dans mon petit soulier: un FnacBook, c'est à dire un livre numérique, aka: une liseuse. Ma première réaction fut de m'asseoir en face du père Noël, qui s'était arrêté pour prendre un café, et de lui dire que non, décidément, je n'ai pas l'usage d'un livre numérique. J'ai beau lire beaucoup, je ne vois pas comment un appareil électronique, donc fragile, et qui fonctionne sur batterie pourrait remplacer un livre en papier, que je considère comme un objet absolument parfait, du moins pour l'usage que j'en ai. Le père Noël me dit de réfléchir et repartit par la cheminée.

A l'heure qu'il est, je n'ai donc pas encore déballé mon FnacBook et je me renseigne sur les détails techniques de la bête. Et LÀ, je dois dire que je suis épaté par ce que je vois sous le capot :

1) GNU/Linux

2) Papier électronique

3) Carte micro SD

4) Accéléromètre

5) Wifi

(et roulements de tambours)

6) Carte SIM GPRS/EDGE/3G (réseau SFR)

Je précise qu'il n'y a aucun abonnement lié à la carte SIM. Mon premier réflexe, c'est donc de me demander si je peux installer un navigateur sur la bête ? Car rends-toi bien compte, cher Journal, des capacités qu'offrirait un tel système : on parle là d'avoir un accès internet illimité pour zéro euro, sur un écran à encre électronique qui tient dans la paume de la main avec une autonomie de quinze heures (ok, je fantasme sur l'autonomie annoncée de l'appareil, qui ne prend probablement pas en compte la connexion 3G).

Bon, en gros : soit je parviens à trouver une manière de modifier l'UI et l'OS pour utiliser un navigateur, soit je rends la bête au magasin. Journal, qu'en penses-tu ? Est-ce que ce projet te paraît réalisable ? -

Site web : Wywiwig et drag & drop

(Journaux LinuxFR)

Bonjour nal

Ne m'en veux pas : j'ai lâché des mots techniques et en anglais dans le titre … mais on est bien chez des techniciens ici, non ? ;-)

La recherche

Ca fait un moment, que je me dis qu'il est bizarre qu'il n'existe pas de gestionnaire de site web qui permette d'éditer et modifier facilement des pages (comme savent le faire les strikingly, weebly, wix et consorts) mais en logiciel libre et installable sur mon serveur.

WordPress (et PluXml et Drupal et d'autres) sont des (CMS aka Content Management System aka Gestionnaire de Contenu). Du coup, ils sont très bien pour gérer des pages de contenu (du blog, un site institutionnel avec pas mal de pages et un formatage identique …) mais ils sont compliqués à utiliser dès qu'on veut faire du site one page ou une landing page avec une mise en page sympa.

Alors bien sur, avec WordPress, il y a des thèmes avec un paquet de plugins qui permettent d'arriver à un résultat très sympa … mais quand on voit les manipulations à effectuer (et la lenteur) ce n'est pas très user friendly … même pour des informaticiens ! Tandis qu'avec les logiciels sus-nommés (strikingly, weebly, wix …) on attrape et dépose sur la page les éléments qu'on veut et on les modifie, comme dans un traitement de texte (ou un logiciel de PAO).Le résultat

Après cette longue introduction, voici le résultat de mes recherches.

Dans le monde libre, je ne connaissais que Oddo qui faisait de la création de site web en drag & drop … mais bon, installer Odoo juste pour faire un site de quelques pages, c'est un peu trop.Alors aujourd'hui, j'ai un peu cherché et j'ai trouvé (dans mon ordre de préférence) :

impresspages

Ca fait exactement, ce que je voulais : du drag & drop wysiwig et libre (licence MIT). De plus, l'ecosystème a l'air assez vif : ils ont pas mal de thèmes et encore plus de plugins. Certains thèmes et plugins ne sont pas gratuits … mais il faut bien que tout le monde mange. Très facile à tester sur leur démo en ligne.Respond

Un CMS qui serait classique si l'édition des pages ne se faisais pas directement dans les pages et avec du drag & drop : une solution à explorer ! Par contre, l'écosystème a l'air faible (5 thèmes, pas de plugins).Microweber CMS

Fait ce que je recherche et bien plus : blog, et e-commerce. Peut-être un peu trop : à étudier.BuilderEngine

Il fait des choses mais a l'air un peu complexe et pas très user friendly (d'après les photos d'écrans, ça ressemble aux usines à gaz WordPress).

Vos expériences

Du coup, je suis à la recherche de retours d'expérience sur ces produits ou d'autres similaires (toujours en Open Source pour installer sur son serveur).

… je posterai également mes propres tests : pour le moment, j'ai juste tester la démo de Impresspages, tous les autres nécessitant de donner son adresse e-mail.

-

Netlibre, un nom de domaine gratuit, facilement administrable

(Dépêches LinuxFR)

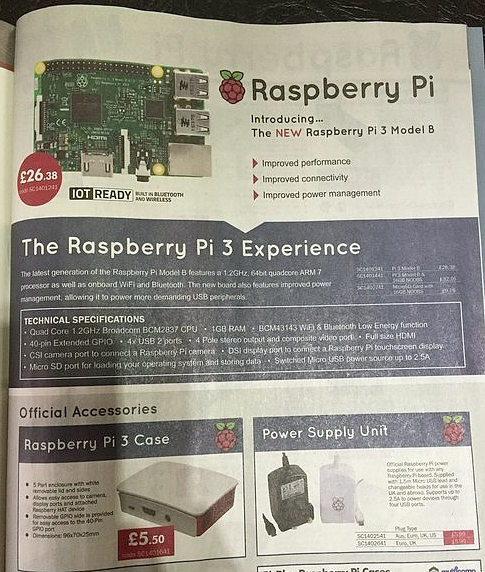

Ça y est, l'heure de l'auto-hébergement est arrivée ! La famille a un Raspberry Pi qui sert à partager les montages des plus belles parties de Call of Duty de grand-maman, grand-papa tient un blog de jardinage en milieu urbain, le plus jeune héberge des serveurs de jeu (minetest, xonotic, redeclipse, teeworlds)… le monde est beau !

Ah mais zut, il faut payer chaque année une petite somme d'argent pour avoir un nom sur le grand 'ternet ! Ce n'est pas bien cher, mais si on veut simplement s'essayer à l'auto-hébergement cela peut être un frein. Il existe cependant une solution…

- lien n°1 : Un DynDNS gratuit, libre, et plus encore.

- lien n°2 : Alsace Réseau Neutre - l'association qui gère l'infrastructure

- lien n°3 : La brique Internet

- lien n°4 : Letsencrypt !

- lien n°5 : #arn sur Geeknode pour nous contacter

- lien n°6 : Le code

Le service netlib.re

Netlib.re est un service en ligne, basé sur du code libre, qui vous permettra de gérer une zone (un nom de sous-domaine) gratuitement. L'interface est simplifiée au possible pour ne pas décourager les moins aguerris d'entre-nous. Il est possible également d'utiliser ce service comme remplaçant direct de DynDNS, puisqu'avec un simple script on peut mettre à jour sa zone, ce qui est pratique pour les personnes qui ont une IP dynamique.

Votre nom de sous-domaine ressemblera à "quelque-chose.netlib.re" ou "quelque-chose.codelib.re", en utilisant les deux seuls noms de domaine actuellement disponibles.

Concrètement, une personne loue un nom de domaine auprès d'un bureau d'enregistrement (moi), et permet à tout le monde de créer des noms de sous-domaines à partir de celui-ci, sans limite de nombre. Le service est hébergé sur l'infrastructure d'Alsace Réseau Neutre, le serveur DNS est redondé (un à Strasbourg, l'autre chez Tetaneutral à Toulouse) n'ayez donc pas trop peur d'une coupure de courant malencontreuse.

L'avenir sera automatique ou ne sera pas.

Toujours dans l'idée de conquérir le monde il serait intéressant d'automatiser la création de comptes pour les nouvelles personnes. Dans le cadre de la brique par exemple, on pourrait penser fournir un nom de sous-domaine à chaque personne en même temps qu'on fournit l'appareil. Ainsi, chaque personne souhaitant devenir indépendante pourrait repartir avec un serveur lui permettant de s'héberger à la maison (site web, lecteur de flux rss, galerie d'images, mails, partage de fichiers, torrents…) mais aussi un nom et pourquoi pas bientôt un certificat pour qu'on soit sûr qu'on discute bien avec Gertrude Touchatonq et pas avec un vilain pirate informatique.

Le choix entre deux noms de domaine, c'est peu !

Pour l'instant n'importe qui peut choisir entre avoir un nom de domaine en « .netlib.re » ou en « .codelib.re ». C'est assez peu, mais n'hésitez pas à me contacter (via Alsace Réseau Neutre) pour aider financièrement à ajouter des noms de domaine disponibles.

Le code de netlib.re (section pour dév. et sys/admin)

Le code de netlib.re est hébergé actuellement sur Github, il est fait avec beaucoup d'amour en langage Perl, et utilise le framework Dancer.

Le README évoluera dans les semaines à venir pour y inclure une procédure pour installer le programme, ainsi que tous les logiciels nécessaires au bon fonctionnement.Pour le moment, le service fonctionne avec un serveur maître Bind9 (avec contrôle rndc), un serveur esclave nsd4 (avec contrôle nsd-control en local), et un serveur web qui discute avec les deux précédents via ssh.

Donc si vous avez déjà quelque-chose ressemblant, mettre en place votre propre instance du programme sera un jeu d'enfant, et à vous le partage de nom de domaine ! -

Neatmail: un client mail minimaliste

(Journaux LinuxFR)

Sommaire

- Ali Gholami Rudi

- Ce que Neatmail ne fait pas

- Ce que Neatmail fait

- Le commande ex de neatmail

- Un script shell comme interface

- Conclusion

J’utilise depuis quelque temps un tout petit client mail, qui ne fait vraiment que le minimum, mais a une interface si particulière, qu’il me semble intéressant de vous le présenter. Il s’agit de Neatmail écrit par Ali Gholami Rudi.

Ali Gholami Rudi

Je connais Ali Gholami Rudi pour une implémentation de Troff à la fois pertinente en termes de fonctionnalités et dont le code source est très propre. Il a aussi écrit un compilateur (neatcc), une libc (neatlibc), et une implémentation de vi. C’est un développeur qui, plutôt qu’une éthique, semble défendre une certaine esthétique du logiciel, que je qualifierai de minimaliste: code source compréhensible par une personne seule, logiciel qui fait peu de choses, mais le fait bien, etc.

Neatmail le client mail qu'il s'est programmé, et celui‐ci met en scène toute l’esthétique de son auteur.

Ce que Neatmail ne fait pas

Neatmail ne fait que gérer un fichier mbox (une concaténation de mails). Ainsi, il ne sait ni rapatrier, ni envoyer les mails, il ne sait ni extraire, ni ajouter de pièce jointes, etc.

Mais en vérité, il n’a pas besoin de faire tout cela, car d’autres logiciels le font. Ali Gholami Rudi propose ainsi un pop3 pour rapatrier les mails depuis un serveur pop3, et smtp pour envoyer ses mails à un serveur smtp. Et il existe dans certaines distributions un ripmime pour extraire les pièces jointes d’un fichier mime.

Ce que Neatmail fait

Neatmail se contente donc d’effectuer des actions sur un fichier mbox. Les actions de bases sont:

‐ mk Génère une liste des mails contenus dans la mbox.

‐ ns Génère une liste des nouveaux mails présents dans la mbox.

‐ pg Affiche un des mails contenu dans la mbox.On peut donc l’utiliser ainsi:

# Obtient les mails pop3 # liste les mails, triés par fil de discussion neatmail mk ‐r ‐st ‐0 18from:48~subject: mbox # affiche le 3e mail neatmail pg mbox 3 # prépare une réponse neatmail pg ‐r mbox 3 > draft.eml vi draft.eml # envoie la réponse tail ‐n+2 draft.eml | smtp # garde une copie de la réponse cat draft.eml >> sent rm draft.emlMais en outre, neatmail peut interpréter les commandes ex contenues dans la liste des mails. Autrement dit, l’utilisateur est invité à ajouter des commandes à cette liste de mails, et donner le tout à neatmail qui se chargera de l’exécution:

neatmail mk ‐r ‐0 18from:48~subject > list.nm vi list.nm neatmail ex < list.nmLe commande ex de neatmail

La commande ex de neatmail prend en entrée une liste de commandes, et les exécute sur un fichier mbox. Elle ignore toutes les lignes hormis celles commençant par deux points (commande ex) ou une lettre majuscule (un mail dans la liste). Les lignes commençant par une lettre majuscule de la forme "R100..", modifient le statut du message dont le nombre suit la lettre (ici, 100). Une telle ligne définit aussi le message actuel, celui sur lequel les commandes sont exécutées. Les commandes ex sont les suivantes:

‐ rm supprime le message courant.

‐ cp copie le message courant dans une mbox donnée.

‐ mv déplace le message courant dans une mbox donnée.

‐ hd modifie l’entête donnée du message courant.

‐ ft passe le message courant à une commande donnée.

‐ w écrit les modifications dans la mbox.

‐ tj joint les fils de discussion en modifiant l’entête "Reply‐To".

‐ ch coupe le message à l’offset indiqué.Par défaut, ces commandes agissent sur le message courant, mais il est aussi possible d’utiliser des adresses du type

2,5rmpour effacer les messages 2 à 5. Il est aussi possible d’utiliser des expressions régulières du type/regex/rm, oùregexest recherché dans le sujet des messages. D’autres champs peuvent être spécifiés en utilisant l’expression^field:value.Un script shell comme interface

Vous allez certainement penser que l’interface est un peu rude… À vrai dire, Ali Gholami Rudi n’utilise pas neatmail directement: un script shell (m) lui sert d’interface. Et c’est là que le logiciel brille: pour peu que l’on ait un peu l’habitude du shell, on peut se créer une interface sur mesure. On peut par exemple imiter l’interface de mh (un autre client mail non interactif un peu oublié). On pourrait créer une interface interactive. Bref, on peut faire ce qu’on veut.

J’utilise par exemple l’interface suivante:

m box inbox # liste les messages contenus dans la mbox inbox. m vi 3 # affiche le message 3 m next # affiche le message 4 m repl # ouvre mon éditeur sur une réponse préformatée au message 4 m add f.pdf # joint f.pdf à ma réponse m send # envoie ma réponse. m R # marque le message 4 comme lu. m com # enregistre les changements dans la mbox (ici, change l’entête du message 4)Conclusion

Au jour le jour, je suis plutôt satisfait de l’ensemble. Le fait de travailler sur les mails en local est plutôt agréable: c’est fluide, offre une grande liberté d’organisation, s’associe bien à un système de sauvegarde ou de gestion de version, etc. Le fait que le client ne soit pas interactif apporte un certain confort d’usage: le shell est sous la main si besoin, je retrouve ma session de travail dans l’état où je l’ai laissée d’un jour à l’autre, il est facile d’implémenter des solutions pour revenir en arrière (cp…). Le fait de coupler le tout avec le shell offre une grande liberté dans la création de l’interface utilisateur.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

LinuxFr.org : première quinzaine de juin 2018

(Journaux LinuxFR)

Nonante huitième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Statistiques

Du 1er au 15 juin 2018

- 1528 commentaires publiés (dont 8 masqués depuis) ;

- 248 tags posés ;

- 80 comptes ouverts (dont 6 fermés depuis) ;

- 35 entrées de forums publiées (dont 0 masquée depuis) ;

- 20 liens publiés (dont 1 masqué depuis) ;

- 21 dépêches publiées ;

- 25 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 1 sondage publié ;

- 0 pages wiki publiées (dont 0 masquée depuis).

Listes de diffusion (hors pourriel)

Liste webmaster@ - [restreint]

- R.A.S.

Liste linuxfr-membres@ — [restreint]

- [membres linuxfr] Bouffe des 20 ans le 28 juin à Paris

Liste meta@ - [restreint]

- [Meta] Incident du jour sur SSL/TLS

- [Meta] Quel avenir pour la tribune ?

Liste moderateurs@ - [restreint]

- [Modérateurs] certificat linuxfr expiré

- [Modérateurs] Incident du jour sur SSL/TLS

- [Modérateurs] Certificat SSL

- [Modérateurs] où se trouve les CSS de Linuxfr

- [Modérateurs] forum - bug pour s'inscrire ?

Liste prizes@ - [restreint]

- [Prizes] LinuxFr prizes recap du samedi 9 juin 2018, 13:35:23 (UTC+0200)

- [Prizes] J'ai gagné un livre!

Liste redacteurs@ - [public]

- [Rédacteurs] Incident du jour sur SSL/TLS

Liste team@ - [restreint]

- [team linuxfr] Certificat SSL du site linuxfr.org expiré

- [team linuxfr] Tweet de Laurent Jouanneau (@ljouanneau)

- [team linuxfr] Incident du jour sur SSL/TLS

- [team linuxfr] Purge du compte X

[*] - [team linuxfr] réouverture de compte

- [team linuxfr] Organisez des événements dans le cadre de la Fête des Possibles, du 15 au 30 septembre 2018

Liste webmaster@ — [restreint]

- R.A.S.

Canal IRC adminsys (résumé)

- certificat X.509 périmé (encore merci à tous ceux qui l'ont signalé), passage à Let's Encrypt et communication post-incident

- renouvellement du domaine (encore merci Yann)

- dernière version de Jessie (8.11) prévu le 23 juin, et ensuite passage en fin de vie

- question relative à la configuration DMARC de la liste Sympa des modérateurs qui change le From de l'émetteur dans certains cas

- rachat de GitHub par Microsoft et dépôts LinuxFr.org. Faut-il bouger et pourquoi.

- Let's Encrypt et HTTP en clair pour le renouvellement ? Voir par exemple la discussion

- discussion sur les aspects sécurité de l'affichage distant d'images sur la tribune

- « 20 ans le bel âge pour mourir », ah non ça parle de Yahoo Messenger, pas de nous

- 20 ans du site et POSS en décembre ?

- courriels envoyés pour préparer les entretiens des 20 ans

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- migration de alpha et main en Jessie

- travaux en cours pour nettoyer le dépôt git d'admin (avec des fichiers générés par ansible notamment). Sans oublier de finaliser la partie Let's Encrypt…

- toujours un conteneur à migrer en Jessie, et ensuite trois en Stretch. Et aussi un hôte Trusty à mettre à jour.

Tribune de rédaction (résumé)

Tribune de modération (résumé)

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- du spam

- améliorations de CSS proposées par voxdemonix

- les admins du site ont des facilités techniques pour traquer les spammeurs et les multis, par rapport aux modérateurs

- retour des Geek Faeries

Commits/pushs de code https://github.com/linuxfrorg/

- (springcleaning) admin-linuxfr.org en cours de conversion vers Ansible

- Allow users to choose the source for their tribune smileys in prefere…

- Add a border for missing title on images

- Fix max height for image on computer screen

Divers

- Geek Faëries, c'était du 1er au 3 juin : conférence « LinuxFr.org, 20 ans que ça geeke » et table ronde « Ces plates‐formes du Libre qui soutiennent les communautés » avec l'Agenda du Libre et En Vente Libre. Encore plein de mercis à Bookynette pour le Village du libre, à l'équipe organisatrice des GF, et à Marco et Marius pour l'hébergement.

- RMLL 2018 Strasbourg : conférence LinuxFr.org : les 20 ans d'un espace d'apprentissage, de communication et d'échange , table ronde Ces plateformes du Libre qui soutiennent les communautés (même thème que celle tenue aux Geek Faëries) et stand

Commentaires : voir le flux atom ouvrir dans le navigateur

-

LinuxFr.org : seconde quinzaine de mai 2018

(Journaux LinuxFR)

Nonante-septième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Avertissement

Ceci est un second message pour prévenir certains de nos visiteurs qui nous transmettent inutilement des infos sensibles via leur lecteur de flux RSS/Atom, infos qui se retrouvent stockées dans nos logs web.

Format par défaut d'un log du serveur web Nginx (source) :

log_format combined '$remote_addr - $remote_user [$time_local] ' '"$request" $status $body_bytes_sent ' '"$http_referer" "$http_user_agent"';Certains utilisateurs nous transmettent leur nom d'utilisateur distant (pas forcément gênant, mais inutile).

Par contre, certains nous transmettent leur nom d'utilisateur ET leur mot de passe. On a ainsi leur nom d'utilisateur dans le champ

remote_usermais aussi leur nom d'utilisateur et leur mot de passe en clair dans le champhttp_referer, sous la formehttp://login:pass@linuxfr.org/journaux.atomouhttps://login:pass@linuxfr.org/news.atom. Cela concerne 6 utilisateurs différents (tous utilisateurs de FreshRSS), dont 1 a été identifié et contacté en privé. Pour les cinq autres, à savoirJeoffrey,jm,lionel,SVNETettitoko, je vous suggère d'arrêter de nous envoyer votre mot de passe, puis de changer de mot de passe étant donné qu'il a fuité, et aussi d'utiliser préférentiellement la version HTTPS du flux souhaité. N'hésitez pas à me contacter en privé si vous avez des questions (oumph CHEZ linuxfr.org).La version FreshRSS 1.11.0 du 2018-06-03 corrige ce problème Strip HTTP credentials from HTTP Referer in SimplePie #1891.

Statistiques

Du 16 au 31 mai 2018

- 1371 commentaires publiés (dont 11 masqués depuis) ;

- 344 tags posés ;

- 99 comptes ouverts (dont 9 fermés depuis) ;

- 33 entrées de forums publiées (dont 1 masquée depuis) ;

- 32 liens publiés (dont 1 masqué depuis) ;

- 26 dépêches publiées ;

- 30 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 0 sondage publié ;

- 2 pages wiki publiées (dont 1 masquée depuis).

Listes de diffusion (hors pourriel)

Liste webmaster@ - [restreint]

- R.A.S.

Liste linuxfr-membres@ — [restreint]

- R.A.S.

Liste meta@ - [restreint]

- R.A.S.

Liste moderateurs@ - [restreint]

- [Modérateurs] Dépêche Refaire linuxfr

- [Modérateurs] contenu problématique

- [Modérateurs] nfsw

- [Modérateurs] URL d'une dépêche

Liste prizes@ - [restreint]

- R.A.S.

Liste redacteurs@ - [public]

- R.A.S.

Liste team@ - [restreint]

- [team linuxfr] Optimize MySQL

- [team linuxfr] Login/mot de passe envoyé en clair dans une URL HTTP sur LinuxFr.org

- [team linuxfr] Login/mot de passe envoyé en clair dans une URL HTTP sur LinuxFr.org

- [team linuxfr] Login/mot de passe envoyé en clair dans une URL HTTP sur LinuxFr.org

- [team linuxfr] Test passage en Jessie

- [team linuxfr] Joker.com: Your domains are about to expire (expiration report)

Liste webmaster@ — [restreint]

- R.A.S.

Canal IRC adminsys (résumé)

- mises à jour de sécurité

- le support sécurité normal pour Debian GNU/Linux 8 Jessie s'arrête au 17 juin

- expiration du certificat au 3 juin et discussion sur le renouvellement

- deux conteneurs mis à jour en Jessie, en attendant le passage en Stretch

- le conteneur de développement redirige tout le trafic en HTTPS désormais

- une boucle de courriels entre un système de ticket et notre gestionnaire de liste de diffusion

- travaux en cours pour nettoyer le dépôt git d'administration système (avec des fichiers générés par l'outil d'automatisation Ansible notamment)

Tribune de rédaction (résumé)

- Migration de GIMP vers GitLab ajoutée dans la dépêche sur la 2.10.2

- Demande de retours sur la dépêche GrafX2 par le développeur principal

- Une correction post-publication

Tribune de modération (résumé)

- du spam (dont un robot réutilisant des extraits de phrases)

- modération d'une image déplacée

- expiration de notre certificat X509 Gandi Wildcard au 3 juin

- évocation du renouvellement du CNNum (on aurait pu mentionner les entrées au comité de prospective de la CNIL)

- migration de deux conteneurs en Debian Jessie

Commits/pushs de code https://github.com/linuxfrorg/

- Merge pull request #222 from fredplante/master

- Fix typo

- (svgtex) fixes duplicate xlink attribute on svg result

- (epub) Use https for LinuxFr.org URLs

Divers

- Geek Faëries du 1 au 3 juin : conférence « LinuxFr.org, 20 ans que ça geeke » et table ronde « Ces plates‐formes du Libre qui soutiennent les communautés » avec l'Agenda du Libre et En Vente Libre. Plein de mercis à Bookynette pour le Village du libre, à l'équipe organisatrice des GF, et à Marco et Marius pour l'hébergement.

- Proposition de conférence soumise + table ronde + demande de stand pour les RMLL 2018 Strasbourg

Commentaires : voir le flux atom ouvrir dans le navigateur

-

LinuxFr.org : première quinzaine de juin 2018

(Journaux LinuxFR)

Nonante-huitième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Statistiques

Du 1er au 15 juin 2018

- 1528 commentaires publiés (dont 8 masqués depuis) ;

- 248 tags posés ;

- 80 comptes ouverts (dont 6 fermés depuis) ;

- 35 entrées de forums publiées (dont 0 masquée depuis) ;

- 20 liens publiés (dont 1 masqué depuis) ;

- 21 dépêches publiées ;

- 25 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 1 sondage publié ;

- 0 pages wiki publiées (dont 0 masquée depuis).

Listes de diffusion (hors pourriel)

Liste webmaster@ - [restreint]

- R.A.S.

Liste linuxfr-membres@ — [restreint]

- [membres linuxfr] Bouffe des 20 ans le 28 juin à Paris

Liste meta@ - [restreint]

- [Meta] Incident du jour sur SSL/TLS

- [Meta] Quel avenir pour la tribune ?

Liste moderateurs@ - [restreint]

- [Modérateurs] certificat linuxfr expiré

- [Modérateurs] Incident du jour sur SSL/TLS

- [Modérateurs] Certificat SSL

- [Modérateurs] où se trouvent les CSS de Linuxfr

[*] - [Modérateurs] forum - bug pour s'inscrire ?

Liste prizes@ - [restreint]

- [Prizes] LinuxFr prizes recap du samedi 9 juin 2018, 13:35:23 (UTC+0200)

- [Prizes] J'ai gagné un livre!

Liste redacteurs@ - [public]

- [Rédacteurs] Incident du jour sur SSL/TLS

Liste team@ - [restreint]

- [team linuxfr] Certificat SSL du site linuxfr.org expiré

- [team linuxfr] Tweet de Laurent Jouanneau (@ljouanneau)

- [team linuxfr] Incident du jour sur SSL/TLS

- [team linuxfr] Purge du compte X

[*] - [team linuxfr] réouverture de compte

- [team linuxfr] Organisez des événements dans le cadre de la Fête des Possibles, du 15 au 30 septembre 2018

Liste webmaster@ — [restreint]

- R.A.S.

Canal IRC adminsys (résumé)

- certificat X.509 périmé (encore merci à tous ceux qui l'ont signalé), passage à Let's Encrypt et communication post-incident

- renouvellement du domaine (encore merci Yann)

- dernière version de Jessie (8.11) prévu le 23 juin, et ensuite passage en fin de vie

- question relative à la configuration DMARC de la liste Sympa des modérateurs qui change le From de l'émetteur dans certains cas

- rachat de GitHub par Microsoft et dépôts LinuxFr.org. Faut-il bouger et pourquoi.

- Let's Encrypt et HTTP en clair pour le renouvellement ? Voir par exemple la discussion

- discussion sur les aspects sécurité de l'affichage distant d'images sur la tribune

- « 20 ans le bel âge pour mourir », ah non ça parle de Yahoo Messenger, pas de nous

- 20 ans du site et POSS en décembre ?

- courriels envoyés pour préparer les entretiens des 20 ans

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- travaux en cours pour nettoyer le dépôt git d'admin (avec des fichiers générés par ansible notamment). Sans oublier de finaliser la partie Let's Encrypt…

- toujours un conteneur à migrer en Jessie, et ensuite trois en Stretch. Et aussi un hôte Trusty à mettre à jour.

Tribune de rédaction (résumé)

Tribune de modération (résumé)

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- du spam

- améliorations de CSS proposées par voxdemonix

- les admins du site ont des facilités techniques pour traquer les spammeurs et les multis, par rapport aux modérateurs

- retour des Geek Faeries

Commits/pushs de code https://github.com/linuxfrorg/

- (springcleaning) admin-linuxfr.org en cours de conversion vers Ansible

- Allow users to choose the source for their tribune smileys in prefere…

- Add a border for missing title on images

- Fix max height for image on computer screen

Divers

- Geek Faëries, c'était du 1er au 3 juin : conférence « LinuxFr.org, 20 ans que ça geeke » et table ronde « Ces plates‐formes du Libre qui soutiennent les communautés » avec l'Agenda du Libre et En Vente Libre. Encore plein de mercis à Bookynette pour le Village du libre, à l'équipe organisatrice des GF, et à Marco et Marius pour l'hébergement.

- RMLL 2018 Strasbourg : conférence LinuxFr.org : les 20 ans d'un espace d'apprentissage, de communication et d'échange, table ronde Ces plateformes du Libre qui soutiennent les communautés (même thème que celle tenue aux Geek Faëries) et stand

Commentaires : voir le flux atom ouvrir dans le navigateur

-

La gestion de l'authentification sous Linux avec PAM

(Laboratoire Linux SUPINFO)

La gestion de l'authentification sous Linux avec PAM

Note: ce document est le second d'un cycle de trois articles sur l'authentification sur les systèmes Linux. Le premier se trouvant ici et le troisième là.

Il est possible de personnaliser finement tous les aspects de l'authentification des utilisateurs Linux et ce pour chaque application du système.

Linux-PAM

En effet, il a été choisi de centraliser le mécanisme d'authentification système sous Linux pour plusieurs raisons :

- afin d'éviter de réimplémenter les mêmes schémas d'authentification dans tous les logiciels.

- ne pas avoir à recompiler toutes les applications lors du changement des méthodes d'authentification.

- permettre à l'administrateur de choisir quel mécanisme d'authentification chaque application utilise.

Ces raisons ont conduit à la naissance de Linux-PAM (pour Pluggable Authentication Modules, soit en français Modules d'Authentification Enfichables).

Avant PAM, pour pouvoir authentifier un utilisateur, une application faisait appel aux bibliothèques du système (via

getpwnam()par exemple) qui la plupart du temps (à moins que NSS ne lui dise d'utiliser une autre source ailleurs) regardaient dans les fichiers/etc/passwdet/etc/shadowpour vérifier l'existence de l'utilisateur et la validité de son mot de passe. Cette technique fonctionnait mais n'était pas très souple pour les raisons évoquées précédemment.Dorénavant, une application compatible PAM délègue cette tâche à Linux-PAM (via un appel à la PAM-API), et celui-ci, suivant les directives inscrites dans ses fichiers de configuration, autorise ou non l'authentification.

Mais PAM ne s'occupe pas seulement de la vérification du mot de passe. Il offre un total de six primitives d'authentification grâce à des modules fournissant certaines fonctions. Ces primitives sont regroupés dans les quatre catégories que voici :

account - Gère la disponibilité du compte. Cette disponibilité regroupe l'accès au serveur sur lequel est stocké le compte, mais aussi si l'utilisateur est autorisé à utiliser ce compte à ce moment donné et par ce moyen. Par exemple on pourra spécifier qu'il n'est autorisé à se connecter qu'entre 8h30 et 17h00 et seulement en console.

auth - Premièrement, c'est dans cette catégorie que l'on vérifie le moyen d'authentification (le mot de passe, le jeton, etc).

- Ensuite c'est ici que l'on affecte les credentials de l'utilisateur, c'est à dire ses privilèges et les groupes auxquels il appartient.

password - Les modules classés dans cette catégorie permettent simplement de mettre à jour le jeton d'authentification de l'utilisateur. Cela peut être parce que ce jeton à expiré, ou, si c'est un mot de passe, parce que l'utilisateur veut le modifier.

session - Mise en place de la session

- Fermeture de la session

Les fichiers de configuration

La configuration de PAM peut se faire de deux façon différentes. Soit dans un fichier unique nommé

/etc/pam.confou soit dans une série de fichiers situés dans le répertoire/etc/pam.d. À noter que la présence de ce répertoire fait que PAM ignorera le fichierpam.conf.

La façon la plus claire de faire et aussi la plus répandue est l'utilisation du dossierpam.det c'est cette méthode que je vais détailler ici.Chaque fichier du répertoire

pam.dgère la configuration du service homonyme. Par exemple le fichier/etc/pam.d/sudoconfigure l'authentification faite par l'intermédiaire de l'outilsudo.

Il y a cependant une exception à cela. Le fichier/etc/pam.d/othercontient la configuration pour les services n'ayant pas leur propre fichier.Ensuite, ces fichiers sont tous organisés suivant le même schéma. Ils sont composés d'une suite d'instructions qui constituent ce que l'on nomme une pile. Chaque instruction est inscrite sur une ligne et chaque ligne est organisée comme ci-dessous :

catégorie contrôle chemin-du-module arguments-du-moduleCes lignes sont donc empilées les unes au-dessus des autres pour combiner les actions des modules qui les composes. On pourra par exemple avoir une ligne ayant un module d'authentification vers un serveur LDAP, suivi d'une autre avec un module d'authentification vers un serveur Kerberos pour enchaîner ces deux méthodes.

Dans l'instruction d'exemple ci-dessus, la

catégorieest choisie parmi celles décrites dans la section précédente (account,auth,passwordousession).Le contrôle est le comportement que la PAM-API doit adopter lorsque le module échoue à sa tâche. Il peut soit prendre la forme d'un simple mot clé, ou soit une forme plus compliquée composée d'une suite de

valeur=actionentourées de crochets.Voici les valeurs que peut prendre ce

contrôlelorsque c'est un simple mot clé :required Si un module requiredéchoue, un statut d'erreur sera retourné par la PAM-API, mais seulement après avoir exécuté les autres instructions du fichier ayant la mêmecatégorie.requisite Comme pour requiredun statut d'erreur est retourné si un modulerequisiteéchoue, mais cependant la main est directement redonné à l'application appelante sans exécuter les modules suivants de la pile. Le statut d'erreur retourné est celui du premier modulerequiredourequisiteà échouer.sufficient Si aucun module précédent n'a échoué et l'exécution de ce module est un succès, les autres instructions de la pile ne sont pas exécutés et la main est redonnée à l'application en lui signalant la validation de l'authentification.

Si le module échoue, son statut de retour est ignoré et le reste des instructions de la pile est exécuté.optionnal Le succès ou l'échec d'un tel module n'est important que s'il est le seul module de la pile de cette catégorie, sinon son statut de retour est ignoré.Quant à la syntaxe complexe du

contrôle, elle a la forme suivante :[valeur1=action1 valeur2=action2 ...]Où

valeurNcorrespond au code de retour de la fonction invoquée dans le module. Ce code de retour dépend des modules et est l'un des suivants (pour connaître ceux que peut renvoyer un module, se reporter à la page de manuel de celui-ci) :success Succès de l'établissement de la session. open_err Le module ne peut pas être ouvert (par exemple il peut ne pas être trouvé). symbol_err Un objet nécessaire au module (par exemple un fichier) est introuvable. service_err Une erreur interne au module est survenue. system_err Une erreur système est survenue (par exemple si l'appel à la PAM-API n'est pas formaté correctement). buf_err Une erreur mémoire est survenue. perm_denied Une permission d'accès à été refusée à l'utilisateur. auth_err L'authentification à échouée. Cette erreur arrive généralement car le jeton (ou mot de passe) est invalide. cred_insufficient Pour une raison quelconque l'application n'a pas les privilèges nécessaires pour authentifier l'utilisateur. authinfo_unavail Les informations d'authentification sont inaccessibles. Par exemple si ces informations sont sur un serveur LDAP et qu'il y a une coupure réseau, ce statut sera retourné. user_unknown L'utilisateur est inconnu. maxtries Le nombre maximal d'essais pour l'authentification à été atteint. new_authtok_reqd Le compte utilisateur est valide mais le jeton à expiré. L'action généralement faite par l'application suite à ce statut est de demander à l'utilisateur de changer son jeton. acct_expired Le compte utilisateur à expiré. session_err L'établissement de la session à échouée. cred_unavail Impossible de retrouver les credentials de l'utilisateur.

Les « credentials » sont tout ce qui identifie de manière unique l'utilisateur, comme par exemple son numéro identifiant, les groupes auquel il appartient, etc.cred_expired Les credentials de l'utilisateur ont expirés. cred_err Impossible d'assigner ses credentials à l'utilisateur. no_module_data Des données spécifiques au module n'ont pas été trouvées. conv_err Erreur de conversation. authtok_err Le module n'a pas été capable d'obtenir un nouveau jeton d'authentification (par exemple lors du changement de celui-ci). authtok_recover_err Le module n'a pas été capable de retrouver l'ancien jeton. authtok_lock_busy Le module n'a pas été capable de changer le jeton d'authentification car celui-ci était verrouillé. authtok_disable_aging Le vieillissement du jeton (en vue de son expiration) à été désactivé. try_again Les tests préalables au changement du jeton d'authentification ont échoués, réessayer plus tard. Ces tests peuvent être par exemple le bon accès au serveur Kerberos si le jeton est un ticket Kerberos. ignore Ignorer le résultat de ce module. Il ne participera donc pas au code de retour de la pile de modules. abort Erreur critique, sortie du module immédiate. authtok_expired Le jeton d'authentification a expiré. module_unknown Le module est inconnu. bad_item L'application a essayée de définir ou d'accéder à un objet non disponible (un fichier par exemple). conv_again incomplete default Toute valeur précédemment listée non mentionnée explicitement. Quant à

actionNil peut prendre une des formes suivantes :ignore Lorsqu'utilisé sur une pile de modules (donc que ce n'est pas le seul module de cette catégorie), le statut de retour de ce module ne participera pas au choix du code de retour envoyé à l'application. bad Cette action indique que le code de retour doit être considéré comme indicatif si le module échoue. Si ce module est le premier de la liste à échouer, sa valeur sera utilisée comme valeur de retour après l'exécution des autres instructions. die Équivalent à bad avec comme effet de quitter immédiatement la pile de modules (sans exécuter les modules suivants) et redonner la main à l'application. ok Cette action dit à PAM que le statut de retour de ce module doit contribuer directement au code de retour global renvoyé par la PAM-API après avoir lu la pile de modules. Autrement dit, si le statut renvoyé initialement devait être PAM_SUCCESS, le statut de retour du module remplacera cette valeur. À noter tout de même, si l'état initial de la pile était un code d'échec, cette valeur ne serait pas remplacée. done Équivalent à ok avec comme effet de quitter immédiatement la pile de modules (sans exécuter les modules suivants) et redonner la main à l'application. N (un entier non signé) Équivalent à ok avec comme effet de sauter les N modules suivants de la pile. Un N égal à 0 n'est pas permis (et serait égal à ok). reset Efface le statut de retour de la pile de modules et recommence avec le prochain module. En sachant cela, les quatre mots clés de la forme simple (required, requisite, sufficient et optionnal) peuvent se représenter de la façon suivante avec la syntaxe complexe :

- required :

[success=ok new_authtok_reqd=ok ignore=ignore default=bad] - requisite :

[success=ok new_authtok_reqd=ok ignore=ignore default=die] - sufficient :

[success=done new_authtok_reqd=done default=ignore] - optionnal :

[success=ok new_authtok_reqd=ok default=ignore]

L'élément suivant des instructions est le

chemin-du-modulequi peut être soit le chemin complet vers le module, ou soit le chemin relatif depuis le dossier par défaut des modules (cela peut être par exemple/lib/security,/lib64/security,/lib/x86_64-linux-gnu/security/, etc).Enfin, on termine les instructions par les

argument-du-module. Pour les connaître, il faut consulter la page de manuel du module en question. Les arguments étant séparés par des espaces, afin de pouvoir placer un espace dans un argument, il faut entourer celui-ci de crochets.Les modules

Les modules sont au cœur du système PAM. C'est grâce à eux que l'on peut définir le schéma d'authentification. Ils s'occupent chacun de la gestion d'un mécanisme d'authentification spécifique.

Voici une liste des modules les plus communs :Nom Catégories compatibles Description courte pam_access.so Toutes Détermine l'endroit depuis lequel l'utilisateur à le droit de se connecter (en local, depuis telle adresse IP, etc...) pam_debug.so Toutes Aide à débugger le comportement de PAM en renvoyant le code de retour demandé par l'utilisateur. pam_deny.so Toutes Refuser l'accès de l'utilisateur. On invoque généralement ce module après avoir essayé les autres méthodes d'authentification. pam_echo.so Toutes Retourne un message texte personnalisé. pam_env.so Auth

SessionPermet de définir les variables et de supprimer les variables d'environnement de la session utilisateur. pam_exec.so Toutes Exécute une commande personnalisée. pam_faildelay.so Auth Change le délais d'attente avant de considérer l'authentification comme un échec pour une application. pam_filter.so Toutes Peut se placer pour filtrer les entrées/sorties entre l'utilisateur et l'application. Il peut par exemple forcer les minuscules surt tout ce que l'utilisateur écrira une fois loggé. Ne fonctionne cependant que pour les tty et les applications basées sur stdin/stdout. pam_ftp.so Auth Permet de se connecter à un serveur FTP. pam_getenv.so Récupère les variables d'environnement depuis le fichier /etc/environment.pam_group.so Auth Assigne à l'utilisateur les groupes auquel il appartient. pam_issue.so Auth Affiche le contenu d'un fichier issue (par défaut /etc/issue) avant le prompt de l'utilisateur.pam_krb5.so Toutes Permet l'authentification via un serveur Kerberos. pam_lastlog.so Session Affiche une ligne d'information sur la dernière connexion de l'utilisateur. pam_ldapd.so Toutes Permet l'authentification via un serveur LDAP. pam_limits.so Session Permet de limiter l'usage des ressources système à l'utilisateur (charge CPU, nombre maximal de processus, etc). pam_listfile.so Toutes Accepte ou refuse l'authentification des utilisateurs en fonction du contenu d'un fichier. pam_localuser.so Toutes N'accepte que les utilisateurs listés dans le fichier /etc/passwd.pam_loginuid Session Applique l'UID de l'utilisateur au processus demandant l'authentification. pam_mail.so Auth

SessionAffiche un message si l'utilisateur a de nouveaux emails. pam_mkhomedir.so Session Créé le répertoire de l'utilisateur ci celui-ci n'existe pas. pam_motd.so Session Affiche le message du jour (par défaut le contenu du fichier /etc/motd).pam_mount.so Auth

SessionDonne la possibilité de monter un disque local ou distant à l'ouverture de la session utilisateur. pam_mysql.so ? Permet l'authentification via un serveur MySQL. pam_namespace.so Session Créé un espace de nommage pour la sessions (voir plus de détails dans la page de manuel du module). pam_nologin.so Account

AuthEmpêche les utilisateurs non-root de se connecter. pam_permit.so Toutes Module qui autorise tout le temps l'accès. À utiliser avec précaution pour des raisons de sécurité. pam_pwhistory.so Password Retient les anciens mots de passe des utilisateurs pour forcer à en avoir un différent lors du renouvellement de celui-ci. pam_rhosts.so Auth Permet l'authentification des utilisateurs sur la machine locale par SSH. pam_rootkok.so Auth Authentifie l'utilisateur sans avoir besoin de rentrer un mot de passe, du moment que son UID est 0 (l'UID de l'utilisateur Root). pam_securetty.so Auth Restreint la connexion de Root aux tty (terminaux) listés dans /etc/securetty.pam_selinux.so Session Met en place le contexte de sécurité pour la session qui s'ouvre. pam_sepermit.so Account

AuthL'authentification est permise seulement si l'utilisateur possède une entrée dans fichier /etc/security/sepermit.conf.pam_shells.so Account

AuthAutorise l'authentification seulement depuis les shells listés dans /etc/shells.pam_succeed_if.so Toutes Valide l'authentification suivant des tests faits sur les caractéristiques de l'utilisateur (nom, UID, GID, shell, home, etc). pam_tally2.so Account

AuthMaintient un compteur du nombre d'essais d'authentifications. Ce compteur est réinitialisé lorsque l'authentification réussie. Utile pour bloquer un compte après un certain nombre de tentatives ratées. pam_time.so Account Permet de restreindre l'accès de l'utilisateur suivant l'heure de la journée, le jour de la semaine, le service sur lequel il se connecte et le terminal depuis lequel il se connecte. pam_timestamp.so Auth

SessionPermet de valider automatiquement l'authentification sans demander de mot de passe si la dernière authentification réussie est inférieur à une certaine date. pam_tty_audit.so Session Permet d'activer l'enregistrement de ce que l'utilisateur écrira dans un tty. pam_umask.so Session Définie l'umask sur la création des fichiers pour la session qui s'ouvre. pam_unix.so Toutes Authentification via les mécanismes standard, c'est à dire en faisant appel aux bibliothèques du système (ces dernières regardant par défaut dans les fichier /etc/passwdet/etc/shadow).pam_userdb Account

AuthAuthentification via une base de données Berkeley DB. pam_warn.so Toutes Module qui inscrit dans les logs l'authentification de l'utilisateur. pam_wheel.so Account

AuthAutorise l'accès seulement aux utilisateurs du groupe wheel(ou du groupe au GID 0 si le groupewheeln'existe pas).pam_winbind.so Toutes Permet l'authentification via un serveur Active Directory. pam_xauth.so Session Permet de conserver les clés xauth (cookies du serveur X) lors du changement de session. Il existe bien d'autres modules qui permettent d'utiliser tout types de serveurs pour l'authentification ou d'autres types de jetons (comme par exemple des cartes magnétiques). Mais vu qu'ils sont utilisés plus rarement, je vous laisse les découvrir par vous même.

Conclusion

PAM est un mécanisme très puissant pour la gestion de l'authentification sous Linux. Bien qu'assez complexe sur certains aspects, il permet à l'administrateur d'avoir un total contrôle de l'accès au système par les utilisateurs. C'est aussi un point clé lorsque l'on veut centraliser l'authentification des machines d'un réseau.

Ressources supplémentaires

- La documentation officiel de Linux-PAM :

http://www.linux-pam.org/Linux-PAM-html/Linux-PAM_SAG.html - La page française de Wikipédia sur PAM :

https://fr.wikipedia.org/wiki/Pluggable_Authentication_Modules - Page PAM de la documentation NetBSD. NetBSD n'utilisant pas la même implémentation de PAM, il y a quelques différences mais une grande partie est commune :

http://www.netbsd.org/docs/guide/en/chap-pam.html - « The Linux-PAM Application Developpers' Guide ». Utile pour connaître la signification des codes de retour des modules :

- Page de manuel PAM(3) :

http://linux.die.net/man/3/pam - Page de manuel pam.d(5) :

http://linux.die.net/man/5/pam.d - Le draft (brouillon) de l'implémentation Linux-PAM :

https://www.kernel.org/pub/linux/libs/pam/pre/doc/draft-morgan-pam-08.txt

-

Que faire avec ses clefs steam inutilisées ?

(Journaux LinuxFR)

Cher lecteur,

Depuis maintenant quelque temps, j'achète de nombreuses compilations de jeux dématérialisés, quand je trouve des jeux linux dedans qui m'intéressent. De plus, je suis abonné au Humble Monthly qui permet à partir d'un prépaiement de 12 dollars (ou moins, en cas d'abonnement sur plusieurs mois) de disposer de jeux sympas, mais que l'on ne connait pas à l'avance.

Avec le temps, je me suis donc retrouvé à la tête de nombreuses clefs steam ou autre, jamais réclamées et qui ne m’intéressent pas car :

- Le jeu n'est pas disponible sous linux,

- Le jeu ne m'intéresse pas,

- Je possède déjà le jeu,

- La réponse D.

Je possède plus de 100 clefs actuellement, mais plus le temps passe, plus ce nombre augmente. Et dans cette liste, il y a quelques jeux un peu anciens, mais plutôt connus et bons (Dark Souls II, Resident Evil 5, SUPERHOT, Total War: WARHAMMER…).

Pour l'instant, j'ai essayé des petites choses avec ces clefs inutil(ilé)es :

- Je les ai données à des amis, collègues, famille… mais nombreux ceux les gamers de mon entourage qui sont dans le même cas que moi et possèdent de quoi jouer pour les prochaines décennies.

- J'en ai "revendu" sur des sites spécialisés. En gros, tu fixes un prix, quelqu'un te l'achète, et ton compte sera trouve crédité de XX % du prix. Par contre, impossible de récupérer des pièces sonnantes et trébuchantes, tu dois utiliser ce montant directement sur le site. Au final, c'est surtout pour faire de l'échange de jeux du point de vue du vendeur. J'ai néanmoins un gros doute sur la légalité de la chose (à la vue de la licence des bundles), et j'ai l'impression que ces sites sont dans le collimateur des éditeurs, vu que de plus en plus de jeux ne peuvent plus être revendus de cette façon.

- Je sais que sur les forums de site spécialisé ou non, des bourses d'échanges s'organisent. Mais il est rare que je trouve des jeux qui m’intéressent, cela prend du temps, et la probabilité que le propriétaire du jeu soit intéressé par un de tes jeux est au final faible.

- D'autres mettent la clé sur le forum Steam du jeu pour que les gens intéressés puisse y jouer.

Je me demande donc, suis-je le seul ici avec ce problème ? Et vous que faites vous avec ces clefs inutilisées ?

-

Dilemme entre vie privée et contrôle de sa machine

(Journaux LinuxFR)

Vous avez sûrement entendu parler de la demande auprès d'Apple d'un juge fédéral américain qui enquête sur la tuerie de San Bernardino de décembre dernier aux États-Unis : ils veulent la possibilité d'utiliser un logiciel pour brute-forcer l'iPhone des « terroristes » afin de récolter plus de preuves pour leur enquête.

En effet, le FBI s'est cassé les dents sur la récupération des données de cette machine : le directeur du FBI s'est même plaint auprès du congrès américain des difficultés causées par les technologies de chiffrement modernes pour les enquêtes qu'il mènent.

Alors, derrière ces plaintes d'un État puissant qui s'énerve de ne pas pouvoir accéder à toute l'information produite dans le monde, d'un côté, on ne peut qu'approuver le combat pour la Liberté et la vie privée, et se dire que ce que fait Apple est bien. Apple a même publié il y a deux jours une réponse au gouvernement américain aux accents patriotiques appuyés : « Nous contestons la demande du FBI avec le plus profond respect pour la démocratie Américaine et avec amour pour notre pays ».

Ils expliquent qu'ils ont tout fait pour répondre de leurs obligations légales, qu'ils ont collaboré avec les autorités pour tout ce qu'ils étaient en capacité de faire, mais qu'il ne peuvent pas fournir de logiciel pour aider à contourner les mécanismes de ralentissement des attaques par force brute (une attente d'un délai augmentant exponentiellement avec le nombre d'essais). Ils expliquent que cela créerait une porte dérobée (backdoor) qui pourrait tout d'un coup être utilisée à mauvais escient, par de mauvais acteurs, car ce logiciel finirait par se retrouver entre de mauvaises mains.

Apple argumente très bien sur la nécessité aujourd'hui du chiffrement pour protéger tout type de données personnelles : conversations, photos, contacts, informations financières, données de santé… Ils expliquent qu'eux-même n'ont pas les clés qui permettent d'accéder aux données de chaque iPhone : preuve s'il en est de leur volonté de protéger leurs clients ! Ils taclent ainsi au passage tous les autres grandes entreprises technologiques qui se gavent sur les données personnelles des personnes du monde entier pour faire leur beurre.

Sauf que…

Sauf qu'il y a un problème : pourquoi le FBI « demande » à Apple de lui fournir un logiciel pour brute-forcer les iPhone ? Ne peut-il pas le faire lui-même ? Je ne vais pas rentrer dans tous les détails cryptographiques, mais vous pourrez trouver plein d'informations très intéressantes sur le fonctionnement des systèmes de sécurité des appareils utilisant iOS dans le guide fournit par Apple. Et donc pour commencer, la mémoire flash de stockage des iPhone est chiffrée en AES : c'est un standard entériné par le gouvernement américain qu'il est impossible de brute-forcer sans y passer très longtemps. À priori même pour le FBI…

Mais la clé permettant de déchiffrer cette mémoire est bien stockée quelque-part, non ? Presque : elle est dérivée d'un UID (propre au téléphone) et d'un GID (commun à une même série de téléphones) qui sont stockés dans la puce, et de manière à ce qu'ils soient impossibles à récupérer : ils ne sortent jamais de cette puce et il n'existe pas de possibilité de les lires…